VII) Déploiement du socle en réseau

jeudi 29 janvier 2015 (), par

Déploiement d’un socle système sur plusieurs postes en même temps

le principe même de drbl-clonezilla est de préparer sur le serveur une tâche à exécuter au prochain démarrage d’un ou plusieurs postes, puis éventuellement provoquer aussitôt ce démarrage par wake-on-lan.

Choisir de restaurer un socle correspondant au modèle/série de poste, pour éviter les problèmes de drivers en cas de matériels différents.

A partir de la version 2, les fichiers de DRBL ne sont plus dans /opt, mais répartis dans /bin, /sbin, /usr/bin, /usr/sbin, /etc/drb et /usr/share/drbl.

Les commandes de DRBL peuvent donc être lancées directement car situées dans les répertoires listés dans la variable PATH.

C’est pourquoi les anciens chemins sont barrés.

- Se connecter en root au serveur en ssh (via l’émulateur putty depuis un poste Windows), ou ouvrir un terminal en connexion graphique vnc, ou encore ouvrir une session ssh depuis webmin.

-

/opt/drbl/sbin/dcspour lancer le serveur Clonezilla (ou l’alias clone en session root, s’il a été défini)

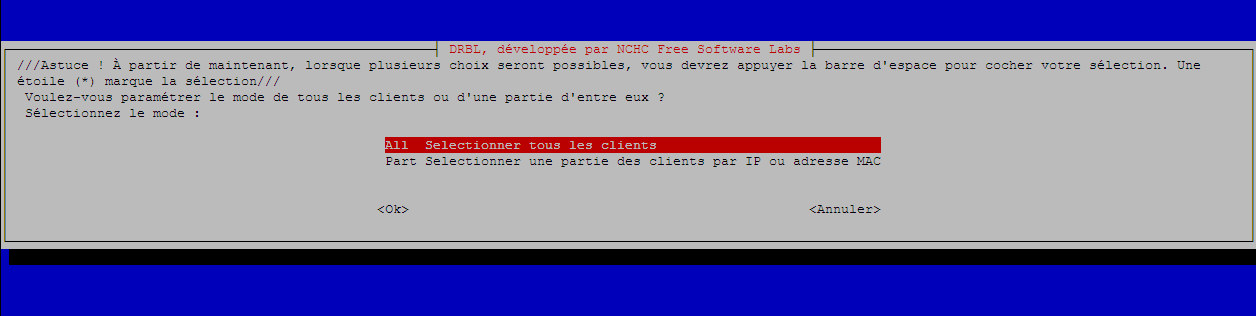

- choisir tout ou partie des postes.

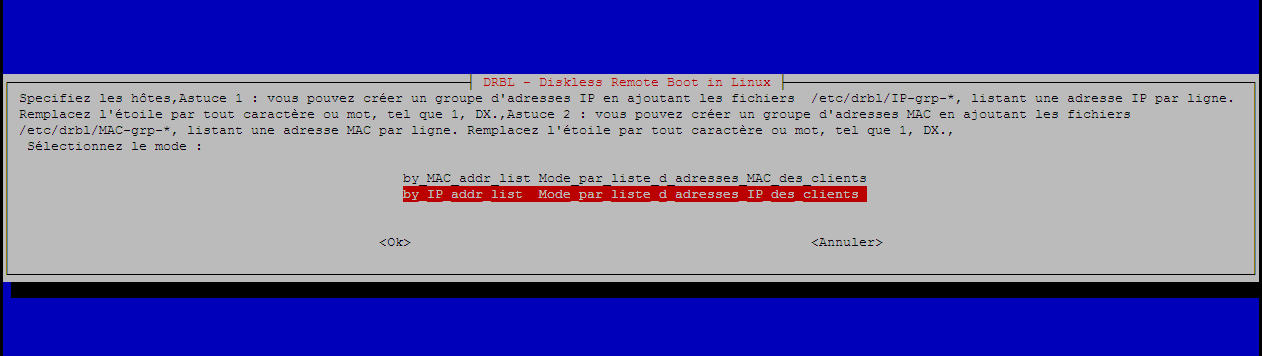

- Il y a 2 listes disponibles : par adresse IP (/etc/drbl/IP_HOST_TABLE) et par adresse Mac (/etc/drbl/HOST_MAC_TABLE)

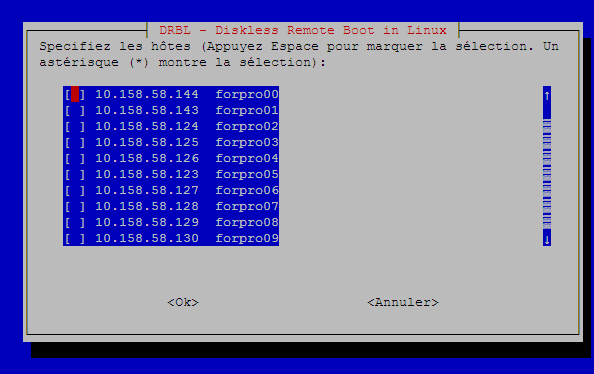

- pour sélectionner un poste, appuyer sur la touche ESPACE. Pour valider, appuyer sur entrée

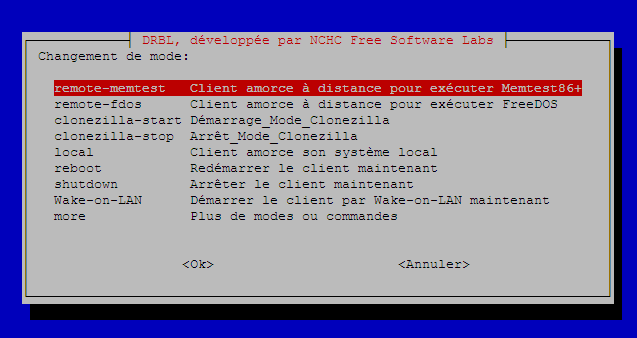

- choisir de démarrer le mode clonezilla (clonezilla-start)

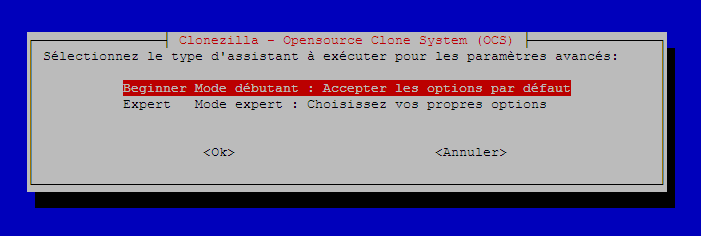

- choisir mode débutant (beginner)

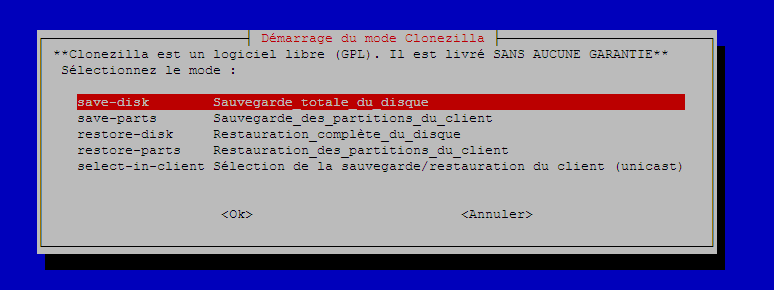

- choisir la tâche : restaurer un disque entier ou une partition

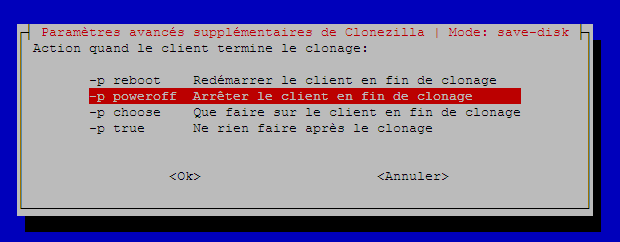

- choisir d’ « arrêter le client en fin de clonage »

- choisir l’image a restaurer

- choisir le disque/la partition à restaurer

- choisir le type de diffusion : unicast pour 1 seul poste, multicast pour plusieurs, afin de travailler en parallèle. Il est préférable d’éviter le broadcast.

- Pour le multicast, choisir la méthode de synchronisation : attendre que n postes aient contacté le serveur avant d’envoyer l’image (au risque qu’un absent bloque les autres), attendre un certain temps (au risque qu’un retardataire ne récupère pas l’image correctement), ou les 2 (un absent ne bloquera pas, mais tant pis pour les retardataires). Cette dernière option (clients+time-to-wait) est fortement recommandée.

- en cas de choix d’option « client-to-wait » ou "clients+time-to-wait", laisser le nombre par défaut. Plus ou moins de postes cela ne change rien en multicast, surtout sur un même VLAN.

- choisir un temps d’attente pas trop grand ni trop petit. 10 minutes semblent un bon compromis. De toute façon, si l’ensemble des postes a contacté le serveur avant ce délai, le serveur enverra aussitôt l’image.

- Vérifier que le serveur se prépare bien à envoyer les paquets sur la bonne interface (la première de /etc/sysconfig/dhcpd)

- Relancer

/opt/drbl/sbin/dcsou l’alias clone (s’il a été défini) - Re-sélectionner les postes.

- Choisir « wake-on-lan » pour les démarrer à distance.

- Attendre que tous les postes notifient le serveur qu’ils ont fini. En général cela prend moins de 20 minutes (quel que soit le nombre de postes) pour un socle Windows.

- Relancer

/opt/drbl/sbin/dcsou l’alias clone (s’il a été défini) - Re-sélectionner les postes. Pour aller plus vite choisir « all ».

- choisir d’arrêter le mode clonezilla (clonezilla-stop).

- Relancer

/opt/drbl/sbin/dcsou l’alias clone (s’il a été défini) - Re-sélectionner les postes.

- choisir « wake-on-lan » afin qu’ils démarrent sur leur nouveau socle et exécutent le script de personnalisation

- attendre 10/15 minutes le temps qu’ils le fassent.

- Relancer

/opt/drbl/sbin/dcsou l’alias clone (s’il a été défini) - Re-sélectionner les postes.

- Choisir « shutdown » pour les éteindre

Si le mode clonezilla n’est pas arrêté pour ces postes, il chercheront à refaire sans cesse la même chose (restauration du socle).

Le ou les postes notifient le serveur lorsqu’ils auront fini.